Fake News, Zensur, Social Scoring: Online-Plattformen wälzen die Wirtschaft um und stellen die Demokratie vor Probleme. Mindestens sieben davon werden uns lange plagen.

Facebook, Amazon und Google sind nicht nur mächtig, weil sie zu den reichsten Konzernen der Welt gehören, sondern weil sie die Gesellschaft umformen. Sie verändern, wie wir uns mit anderen vernetzen, wofür wir Geld ausgeben, was wir über die Welt wissen und wie wir uns als Person präsentieren. Ihr Einfluss auf die Gesellschaft ist nicht nur wirtschaftlich, sondern auch politisch und sozial.

Jede Woche lese ich Artikel darüber, wie die großen Tech-Konzerne Probleme und Konflikte hervorrufen. Ich glaube, wir können diese Probleme und Konflikte besser verstehen und sogar teilweise vorhersagen, wenn wir Facebook, Amazon, Google und die anderen nicht nur als Konzerne betrachten, sondern als eine neue Art von gesellschaftlichen Akteuren: Plattformen.

In diesem Blogbeitrag definiere ich zuerst, was ich mit Plattform meine. Dann beschreibe ich, wie Plattformen durch ihre besondere Rolle sieben gesellschaftliche Konflikte provozieren. Dabei mache ich deutlich, warum diese Konflikte meiner Meinung nach nicht lösbar sind, sondern nur verhandelbar. Die Konflikte entstehen nämlich im Spannungsfeld zwischen einander widerstrebenden Interessen, also in einem Gebiet, das nicht zur Ruhe kommen kann.

Was sind Plattformen?

Der Kommunikationsforscher Tarleton Gillespie beschreibt das Wort Plattform als „spezifisch genug, um immerhin etwas zu bedeuten, und vage genug, um bei vielen Anlässen und Zielgruppen etwas zu taugen“. (PDF) Der Ökonom Nick Srnicek und der Autor Sascha Lobo sehen in Plattformen sogar die Form einer neuen kapitalistischen Wirtschaftsordnung.

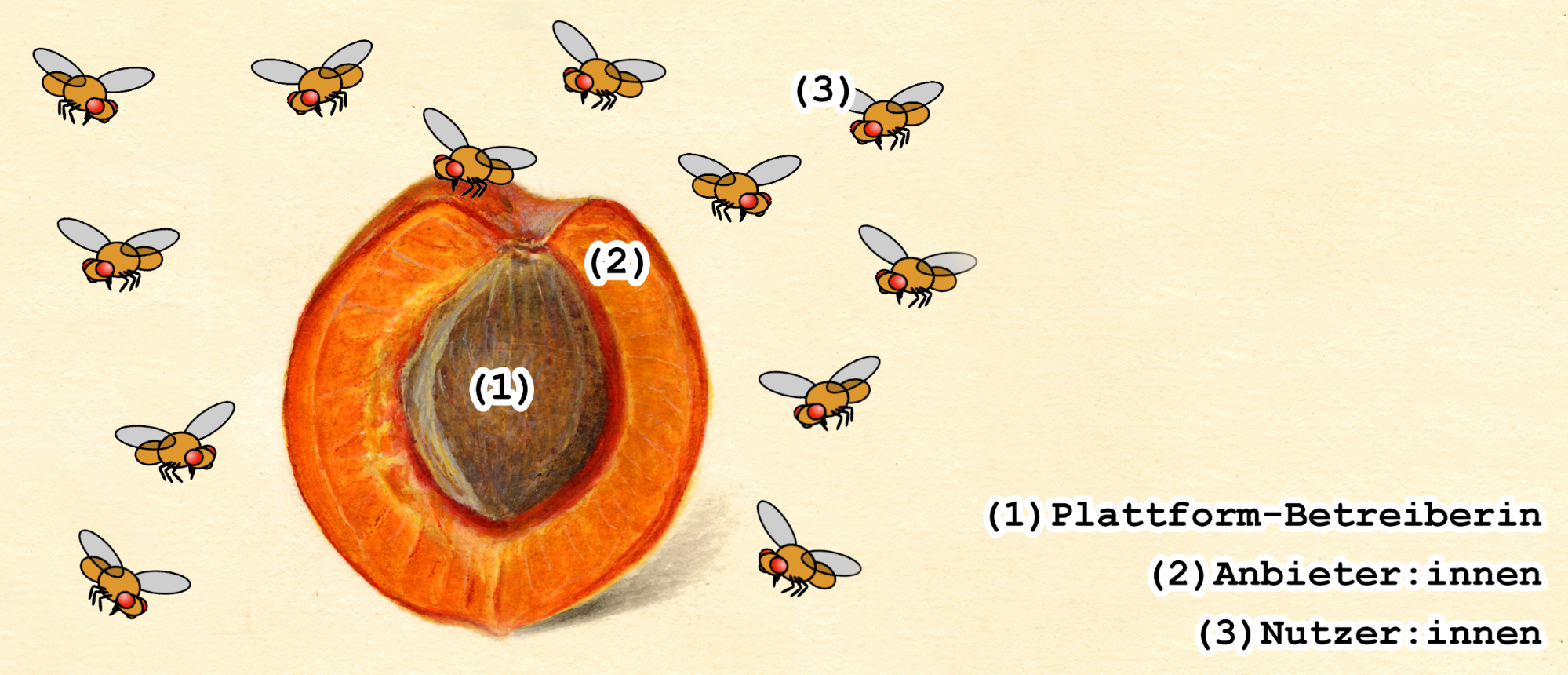

Bevor ich wissenschaftliche Definitionen zitiere, mache ich es so einfach wie möglich und behaupte: Plattformen sind Aprikosen. Sie bestehen aus einem Kern und Fruchtfleisch und locken Fliegen an.

Der Kern der Aprikose ist die Plattform-Betreiberin, zum Beispiel der Google Play Store, die wichtigste Plattform für Android-Apps. Das Fruchtfleisch bilden die Anbieter:innen, die auf der Plattform ihre Inhalte, Dienstleistungen oder Produkte präsentieren; im Beispiel sind das alle großen und kleinen Android-App-Entwickler:innen. Die Fliegen sind alle, die als Nutzer:innen um die Inhalte schwirren und sich Apps herunterladen.

Aprikose: Newton, Amanda Almira, ca. 1860-1943, Public domain | Fliegen: Ilmari Karonen, Public domain | Bearbreitung: S.M.

Der Vergleich lässt sich auch auf YouTube anwenden: Die Website mit all ihren Funktionen ist der Kern; die YouTuber:innen und Anzeigenkund:innen liefern das Fruchtfleisch; und die Fliegen, das sind all die Zuschauer:innen, die Videos und Werbeanzeigen konsumieren.

YouTube funktioniert also in doppelter Hinsicht als Plattform: Die meisten erleben YouTube als Plattform für interessante Videos, zwischen denen manchmal Werbung läuft. Die Werbeindustrie sieht das anders und nutzt YouTube als Plattform zum Ausspielen von Werbung. Welche Art von Content dabei die Aufmerksamkeit der Zielgruppe bindet, ist Nebensache.

Das Beispiel YouTube zeigt außerdem, wie leicht Online-Plattformen es uns machen, sowohl zum Fruchtfleisch als auch zu den Fliegen zu gehören: Innerhalb von Sekunden können wir unsere Rolle als Zuschauende verlassen und einen eigenen YouTube-Kanal eröffnen, eine eigene Anzeige schalten. Auf Messaging-Plattformen wie WhatsApp sind die Rollen sogar verschmolzen, wir produzieren und konsumieren Inhalte im ständigen Wechsel.

Eine weniger fruchtige Definition für Plattformen liefern die Wirtschaftsforscher Jean-Charles Rochet und Jean Tirole im Jahr 2005 in ihrem Aufsatz Two-Sided Markets: A Progress Report (PDF). Plattformen organisieren den Forschenden zufolge sogenannte two-sided markets, also Märkte mit zwei Seiten. Diese zwei Seiten sind Anbieter:innen und Endkund:innen, wir erinnern uns: Fruchtfleisch und Fliegen.

„A platform enables or facilitates the interaction between the two sides provided that they indeed want to interact. The interaction can be pretty much anything, but must be identified clearly.“ (Rochet/ Triole)

In eine ähnliche Richtung geht die Definition von Geoffrey Parker (PDF). Der Ingenieurwissenschaftler definiert Plattformen als „nexus of rules and infrastructure that facilitate interactions among network users“. Fruchtfleisch und Fliegen bezeichnet er als „Supplier“ und „Buyer“.

Bei diesen wirtschaftswissenschaftlich geprägten Definitionen kommen meiner Meinung nach Social-Media-Plattformen zu kurz, auf denen Nutzer:innen zunächst ohne kommerzielle Interessen Inhalte tauschen. Deshalb will ich es hier mit einer eigenen Definition probieren:

Eine Plattform ist ein öffentlich zugängliches Online-Angebot, das spezifische Kanäle für Kommunikation bereitstellt. Auf diesen Kanälen werden Inhalte, Dienstleistungen und Produkte vermittelt. Sie stammen nicht ausschließlich von der Plattform-Betreiberin selbst, sondern vor allem von Nutzer:innen und Firmen. Nutzer:innen und Firmen können auf der Plattform nahezu unbegrenzt Inhalte, Dienstleistungen und Produkte anbieten und empfangen.

Weil eine Online-Plattform digital funktioniert, entstehen permanent Datenströme, die sie zur eigenen Optimierung nutzen kann. Eine Plattform hat das Potenzial, einen Netzwerkeffekt auszulösen: Das heißt, die Plattform wird zunehmend nützlicher, je mehr Menschen sie nutzen, und sie zieht noch mehr Menschen an, sobald sie nützlicher wird. Dadurch ist eine Plattform auch potenziell disruptiv, das heißt, sie kann bestehende Dienstleistungen vom Markt verdrängen.

Beispiel Ebay Kleinanzeigen: Die Website ist öffentlich zugänglich. Die spezifischen Kanäle für Kommunikation sind Inserate und private Chats zwischen Verkäufer:innen und Interessent:innen. Die Inhalte sind meist Schnäppchen von Privatpersonen, es gibt aber auch Dienstleistungen wie etwa kleine Reparaturen. Die Anzahl möglicher Inserate auf der Plattform ist schier unbegrenzt. Weil viele Menschen dort aktiv sind, finden sich schnell Interessent:innen für Angebote, und weil das mit dem Verkaufen dort ganz gut klappt, nutzen auch viele Menschen die Plattform. Durch Ebay Kleinanzeigen werden Zeitungsannoncen und Flohmärkte weniger wichtig.

Darüber hinaus gibt es einige typische Eigenschaften, die zumindest viele Plattformen gemeinsam haben. Meist werden Plattformen von Unternehmen betrieben. Geld verdient eine Plattform meist durch den Verkauf von Werbeplätzen, Abos oder Vermittlungsgebühren. Die Teilhabe reguliert eine Plattform meist durch Nutzungsbedingungen, entsprechend darf sie Nutzer:innen eigenständig ausschließen. Meist bemühen sich Plattformen um ein unpolitisches Image. Oft entstehen auf Plattformen neue Vergemeinschaftungen, die sonst nicht entstanden wären. Meist arbeiten Plattformen über Ländergrenzen hinweg und überfordern dadurch nationale Gesetzgeber:innen.

Hier eine Übersicht mit einigen Plattformen, was sie vermitteln und wen sie verdrängen.

Als nächstes beschreibe ich sieben grundlegende Probleme, die Plattformen in der digitalen Gesellschaft provozieren. Allen Problemen liegt derselbe Konflikt zugrunde: Eine Plattform startet zwar meist als wirtschaftliche Akteurin, aber sobald sie erfolgreich wird, sind ihre Entscheidungen auch politisch. Denn durch Netzwerkeffekte und Disruption sind mehr und mehr Menschen auf der Plattform aktiv, und Entscheidungen der Plattform-Betreiber:innen haben einen massiven Einfluss auf die Öffentlichkeit. Große Plattformen befinden sich also in einer Doppelrolle zwischen Politik und Wirtschaft, in der sich finanzielle Interessen und öffentliche Verantwortung gegenüberstehen.

Hinzu kommt ein zusätzlicher Zwist, den Plattformen innerhalb ihrer politischen Rolle aushalten müssen. Zum einen haben Plattformen Verpflichtungen für das Gemeinwohl, zum anderen versuchen Regierungen vermehrt, die Plattformen für autoritäre Zwecke in die Pflicht zu nehmen.

1. Das Zensur-Problem

Die wirtschaftliche Rolle: Jeder hat das Recht, seine Meinung frei zu äußern – aber keiner hat die Pflicht, jedem Spinner dafür eine Bühne zu bieten. Das virtuelle Hausrecht erlaubt es Plattformen, unerwünschte Äußerungen zu löschen oder für andere Nutzer:innen schwerer zugänglich zu machen. Über die zugrunde liegenden Regeln (Community-Richtlinien) und deren Durchsetzung (Content Moderation) entscheiden die Plattform-Betreiber:innen selbst. Schließlich gehört die Plattform ja ihnen.

Die politische Rolle: Das virtuelle Hausrecht von Plattformen kann sich in Zensur verwandeln.

Facebook, YouTube, Twitter aber auch die Google-Suche sind längst ein Ort für öffentliche Repräsentation geworden. Soziale Medien sind inzwischen so wichtig, dass sie sogar Einfluss auf politische Wahlen haben. Wer von den großen Plattformen blockiert wird, ist deutlich weniger sichtbar. Theoretisch könnten blockierte Interessengruppen ihre Beiträge zwar woanders hochladen, etwa auf einem WordPress-Blog – de facto werden sie dort aber kaum wahrgenommen.

In einer Demokratie haben selbst Faschist:innen das Recht, sichtbar auf öffentlicher Straße zu protestieren. Sie dürfen Flyer verteilen und Büros eröffnen. Reguliert wird das von gewählten, politischen Vertreter:innen. In der Öffentlichkeit der sozialen Medien sieht das anders aus. Hier können Plattform-Betreiber:innen die Fanpages, Blogs und Social-Media-Posts von unerwünschten Personen und Gruppen auf eigene Faust für verboten erklären und entfernen. Die Moderationsregeln einer Plattform können auf diese Weise zu den Grenzen des Sagbaren für Milliarden Menschen werden.

Das Zensur-Problem stört die wenigsten, wenn Facebook Rassist:innen und Verschwörungstheoretiker:innen von der Plattform schmeißt, Holocaustleugnungen und Enthauptungsvideos löscht. Ganz anders ist aber die Situation, wenn Google auf politischen Druck von China eine zensierte Suchmaschine bereitstellen soll. Immerhin hat der Konzern das Vorhaben spätestens im Sommer 2019 aufgegeben. Die Balance zwischen Dulden und Zensieren lässt sich wohl nur gesellschaftlich aushandeln, wenn Plattform ihre Regeln offenlegen und zur öffentlichen Diskussion stellen.

Beispiele aus der Vergangenheit

- 08.11.2016 Journalist:innen protestieren, nachdem Facebook einen redaktionellen Beitrag löscht: Das historische Foto der Vietnamesin Kim Phuc, die als Kind vor einem Napalm-Angriff floh (BBC)

- 24.01.2018 YouTube sperrt die Episode einer öffentlich-rechtlichen Webserie wegen einer Sexszene, obwohl der deutsche Jugendschutz eine Empfehlung ab 12 Jahren ausgesprochen hat (WZ)

- 31.05.2018 Facebook und Instagram werfen die rechtsextreme Identitäre Bewegung Österreich raus (Der Standard)

- 13.05.2019 Twitter sperrt offenbar versehentlich den Account der Jüdischen Allgemeinen, nachdem sie in einem AfD-kritischen Beitrag gepostet hat (Tagesschau)

- 04.06.2019 Aktivist:innen fordern Facebook auf, nicht länger die Abbildung weiblicher Nippel zu verbieten (Watson)

- 12.12.2019 YouTube will künftig auch „verschleierte oder indirekte Drohungen“ löschen (Golem)

- 18.12.2019 TikTok entfernt in mehreren Fällen Videos, die Polizeigewalt dokumentieren, spricht von Guidelines fürs „Wohlbefinden“ der Community (Vice)

2. Das Meinungsmacht-Problem

Die wirtschaftliche Rolle: Eine Plattform darf die Inhalte prominent platzieren, die ihr finanziell am meisten nützen. Das sind zum Beispiel Amazon-Produkte, die sich gut verkaufen lassen, Facebook-Posts, die viel geteilt werden, oder YouTube-Videos, die viele Zuschauende binden. Eigenproduktionen, sogenannte „Originals“ darf die Plattform besonders hervorheben. Mithilfe von Algorithmen und Content Moderation bestimmen Plattformen, welche Inhalte auf den Trending-Seiten und in den Newsfeeds landen und welche nicht.

Die politische Rolle: Durch ihr riesiges Publikum haben Plattformen eine Meinungsmacht und bestimmen mit ihren Inhalten das Meinungsklima in der Gesellschaft.

In keinem Fall wurde das bisher so intensiv diskutiert wie bei der Wahl Donald Trumps zum US-Präsidenten im Jahr 2016. Das Problem: Soziale Netzwerke, allen voran Facebook, haben Desinformation, Fake News und Hetze einem breiten Publikum zugänglich gemacht. Es waren irreführende und emotionalisierende Inhalte, die Trump nutzten und seiner Rivalin Hillary Clinton schadeten. Das geschah teilweise mithilfe von bezahlten Anzeigen, teilweise unter Einfluss russischer Propaganda-Profis wie der Troll-Truppe namens Internet Research Agency. YouTube wiederum steht seit Jahren in der Kritik, weil der Empfehlungsalgorithmus Zuschauer zu Videos mit Verschwörungstheorien lockt. Sind die Plattformen dafür verantwortlich?

Häufig argumentieren Plattformen wie Facebook und YouTube dagegen und drehen die Verantwortung um: Demnach bestimmten nicht etwa die Plattformen, was Nutzer:innen zu sehen bekommen, sondern Nutzer:innen bestimmen durch ihr Verhalten, wie die Algorithmen Inhalte kuratieren. Mit dieser Argumentation wehren sich Plattformen dagegen, als Publisher wahrgenommen zu werden, die Inhalte redaktionell kuratieren. Das hat einen Grund, denn als Publisher hätten Plattformen auch juristisch mehr Verantwortung für die gezeigten Inhalte.

Die Rolle einer Plattform liegt wohl in der Mitte zwischen Publisherin und Speicherplatz-Anbieterin. Eine entscheidende Verantwortung für die gesellschaftliche Wirkung der gezeigten Inhalte hat sie auf jeden Fall. Die Newsfeeds und Trendseiten beeinflussen die Öffentlichkeit ähnlich stark wie die Schlagzeilen großer Zeitungen. Plattformen können damit zur gesellschaftlichen Spaltung beitragen, Diskriminierung fördern und für Propaganda missbraucht werden.

Im Fall der russischen Propaganda zur US-Präsidentschaftswahl hat Facebook eine 180-Grad-Wende hingelegt. Im Wahljahr 2016 hat Konzernchef Mark Zuckerberg noch gesagt, es sei eine „verrückte Idee“, dass Russland mittels Facebook einen Einfluss auf die Wahl gehabt haben könne. Von diesem Standpunkt ist Facebook seitdem schrittweise zurückgewichen. Inzwischen widerspricht Zuckerberg sogar Donald Trump, der den russischen Einfluss leugnet.

Mit welchen Regeln für Newsfeeds und Trendseiten können Plattformen also ihrer öffentlichen Verantwortung gerecht werden, und wie ließe sich das kontrollieren? Die Debatte wird erschwert, weil Plattformen die Systeme hinter ihren Trendseiten und Newsfeeds streng geheim halten – unter anderem, damit niemand Schlupflöcher entdeckt und Trends manipuliert. Das Aushandeln des Meinungsmacht-Problems passiert derzeit durch Wellen öffentlicher Kritik, häufig ausgelöst durch Medienberichte, und die Plattformen justieren nach.

Ändern könnte das der Entwurf des neuen Medienstaatsvertrags, der in Deutschland im Herbst 2020 in Kraft treten könnte. Er gibt Plattformen neue Informationspflichten: Je nach Auslegung des Entwurfs müssen Plattformen künftig offenlegen, warum sie Inhalte prominent platziert haben. Unklar ist aber noch, wie konkret Plattformen dabei wirklich antworten müssen.

Beispiele aus der Vergangenheit

- 12.01.2018 Nach der Wahl Donald Trumps zum US-Präsidenten baut Facebook seinen Newsfeed um: weniger nachrichtliche Inhalte, mehr Updates von Kontakten (Süddeutsche)

- 13.03.2018 Desinformation auf Facebook hat einen erheblichen Anteil an der Vertreibung der Rohingya in Myanmar (Handelsblatt)

- 11.04.2018 Der CEO von TikTok verpflichtet sich einem offenen Brief der „Lenkung der öffentlichen Meinung“ im Sinn der chinesischen Regierung (Social Media Watchblog)

- 28.01.2019 YouTube verändert seine Empfehlungs-Algorithmen, um Fake News und Verschwörungstheorien einzudämmen (FAZ)

- 30.10.2019 Twitter verbannt politische Werbung grundsätzlich (DW)

- 02.12.2019 TikTok verspricht Aufklärung über seine Richtlinien, nachdem Recherchen von netzpolitik.org diskriminierende Content Moderation aufdecken (netzpolitik.org)

3. Das Polizei-Problem

Die wirtschaftliche Rolle: Als Vermittlerin ist eine Plattform nicht für die Inhalte ihrer Nutzer:innen verantwortlich. Wer mit seinen Inhalten auf einer Plattform gegen Gesetze verstößt, muss dafür persönlich Verantwortung übernehmen. Als Unternehmen sieht sich eine Plattform auch nicht in der Pflicht, aktiv nach Menschen zu suchen, die mithilfe der Plattform Rechtsverstöße begehen. Wenn eine Firma Küchenmesser verkauft, muss sie ja auch nicht Ausschau nach Messerstechern halten. Erst wenn die Plattform von einem Verstoß erfährt, wird sie tätig und entfernt beispielsweise einen urheberrechtlich geschützten Kinofilm, löscht einen volksverhetzenden Facebook-Post oder wirft Hakenkreuz-Merchandise aus dem Online-Shop. Dieses Prinzip heißt notice and takedown.

Die politische Rolle: Wenn Plattformen nicht gegen Rechtsverstöße vorgehen, dulden sie aktiv Kriminelle. Umgekehrt können sich Plattformen aber in eine privatwirtschatliche Polizei verwandeln, wenn sie alle Hinweisen aus ihrem Datenschatz nachgehen.

Rechtsverstöße auf Plattformen sind nicht automatisch Einzelfälle. Was digital passiert, lässt sich skalieren und massenhaft wiederholen: Zum Beispiel können Schwärme aus Fake-Accounts massenhaft Facebook-Beiträge mit Volksverhetzung oder YouTube-Videos mit Terror-Propaganda verbreiten. Das Prinzip notice and takedown wird dadurch zur Sisyphos-Arbeit. In einigen Fällen haben Plattformen ihre Verantwortung anerkannt und automatisierte Lösungen entwickelt. Wenn zum Beispiel Videos nicht erneut auf einer Plattform landen sollen, lässt sich davon ein digitaler Fingerabdruck, ein sogenannter Hash, erstellen. Alle neuen Uploads auf der Plattform werden dann mit einer Datenbank aus Hashes abgeglichen. Wenn ein Video in der Datenbank auftaucht, wird es gar nicht erst veröffentlicht. Auf diese Weise lässt sich die Verbreitung von urheberrechtlich geschützten Filmen und Serien, Terrorvideos, sogenanntem Revenge Porn und sogenannter Kinderpornografie verhindern. Inzwischen nutzen unter anderem Facebook, Instagram, Twitter, Microsoft, YouTube und Reddit eine gemeinsame Hash-Datenbank, um die Verbreitung terroristischer Inhalte einzudämmen.

Die Plattformen entscheiden in diesem Fall, was verboten ist, und ziehen selbstständig die Konsequenzen. In vielen Fällen gibt es dagegen wenig Einwände: Klar ist es sinnvoll, Videos mit Folterszenen und Enthauptungen zu löschen. Aber wie weit sollten Plattformen ihre Aufgaben als Hilfssheriff ausdehnen? Immerhin sind die Mitarbeiter der Plattform keine Polizist:innen und stehen nicht unter öffentlicher Kontrolle.

Im Oktober 2019 hat der EuGH anhand eines Falles entschieden: Facebook soll bei strafbaren Beleidigungen nicht nur die beanstandeten Posts löschen, sondern auch alle weiteren ähnlichen Posts. Fragt sich nur: Was heißt hier ähnlich? Soll Facebook als Meinungspolizei täglich Millionen neuer Beiträge abklopfen und dabei massenhaft löschen? Aktuell ist noch nicht klar, wie sich die Entscheidung auf die Löschpraxis der Plattformen auswirkt.

Plattformen hätten darüber hinaus genug Wissen, um jede Menge weiterer Rechtsverstöße zu verfolgen. Theoretisch können Plattformen intensive Polizeiarbeit machen. Das betrifft nicht nur Personen, die justiziable Beleidigungen posten. Immer wieder verraten Nutzer:innen direkt oder indirekt, dass sie Gesetze verletzen: Instagram-Nutzer:innen zeigen sich mit illegalen Drogen, Standortdaten entlarven Falschparkende, Menschen, die ihren neuen Wohnsitz nicht gemeldet haben, bestellen Pakete nachhause – und in so manchen privaten Chatprotokollen lassen sich bestimmt Hinweise für allerlei sonstige Delikte finden.

Ab wann vernachlässigen Plattformen ihre Verantwortung – und ab wann überstrapazieren sie ihre Macht? Die Eigeninitiative von Plattformen muss enge Grenze haben, sonst verwandeln sich die Hilfssheriffs in eine dystopische Big-Brother-Privatpolizei. Zugleich können auch verkorkste Gesetze dazu führen, dass sich Plattformen in schwer erträgliche Kontrollfreaks verwandeln: Expert:innen befürchten, dass die 2019 beschlossene Reform des EU-Urheber:innenrechts das freie Internet, wie wir es kennen, durch Uploadfilter bedroht.

Beispiele aus der Vergangenheit

- 17.08.2018 Ebay bekommt die Geschäfte mit verbotenem Nazi-Merch nicht in den Griff (Vice)

- 12.10.2019 PornHub und xHamster überprüfen neue Video-Uploads lax, sodass sexualisierte Gewalt erst einmal online bleibt (Vice)

- 02.11.2019 Facebook möchte Hassrede nicht automatisch der Staatsanwaltschaft melden (Tagesschau)

- 06.12.2019 Soziale Medien sollen Hasspostings künftig dem BKA melden (Spiegel)

4. Das Überwachungs-Problem

Die wirtschaftliche Rolle: Eine Plattform muss viele Informationen und Aktivitäten ihrer Nutzer:innen speichern und auswerten, um überhaupt zu funktionieren. Zum Beispiel braucht Amazon fürs Verschicken eines Pakets schon Name, Adresse und Kontodaten. Um Betrug zu verhindern, untersucht Amazon außerdem technische Details wie IP-Adresse und Browserversion. Facebook verdient sein Geld mit dem Ausspielen von Werbung, entsprechend muss die Plattform Daten sammeln, um Zielgruppen einzugrenzen.

Sekündlich liefern Nutzer:innen einer Plattform neue Daten, denn alle Tätigkeiten, vom Herumscrollen übers Tippen bis hin zum Liken von Inhalten, sind digitale Informationen, die sich massenhaft sammeln und auswerten lassen. Während sich die Datenbank der Shopping-Plattform Amazon von alleine füllt, müsste die Besitzerin eines Kiosks für einen Bruchteil der Erkenntnisse aktiv Strichlisten führen. In ihrem Datenschatz sucht die Plattform stets nach Möglichkeiten, besser zu wirtschaften.

Die politische Rolle: Durch die gigantische Nutzer:innenzahl ist das Datensammeln einer großen Plattform niemals nur eine schlichte Kunden:innen-Analyse. Es ist immer auch die Erfassung und potenzielle Überwachung eines großen Teils der Bevölkerung.

Mitarbeiter:innen in Meinungsforschungs-Instituten telefonieren sich die Ohrmuscheln heiß, um einer kleinen vierstelligen Zahl an Menschen ein paar Fragen zu stellen; die Ergebnisse werden in Nachrichtensendungen präsentiert und von der Wissenschaft ausgewertet. Gleichzeitig verraten nicht Tausende, sondern Milliarden Menschen auf Facebook, was ihnen gefällt und was nicht, wo sie wohnen und wie alt sie sind, und das über Jahre hinweg – die wohl detaillierteste Bevölkerungsumfrage der Menschheit.

Daten beantworten immer mehr als die Frage, für die sie erhoben wurden, besonders wenn sie massenhaft gesammelt, miteinander verknüpft oder gar missbraucht werden. Ein Sprecher der Pornoplattform xHamster sagt 2019 gegenüber VICE.com: Er könne sich vorstellen, dass homofeindliche Regierungen gerne die Daten von xHamster-Nutzer:innen hätten, um Homosexuelle zu verfolgen. Das ist nicht gerade beruhigend. In den USA hat Amazon Polizeibehörden dazu motiviert, die Überwachungskamera namens Amazon Ring zu bewerben – im Gegenzug winkte den Ermittler:innen ein praktischer Zugang zu Videoaufzeichnungen.

Unter der Kontrolle von autoritären Politiker:innen ließe sich aus den Daten der Plattformen ein totalitärer Überwachungsstaat bauen, der seine Bürger:innen anhand tausender Datenpunkte in Echtzeit verfolgt und kontrolliert. Dass Plattformen ihre Datenschätze hüten und Staaten den Datenschutz gesetzlich garantieren, ist also von größtem gesellschaftlichem Interesse. Dabei zeigen Datenleaks der Vergangenheit: Wirklich sicher sind allein Daten, die gar nicht erst erhoben wurden.

Das Überwachungs-Problem richtet sich nicht nur rückblickend auf vergangenes Verhalten, das erfasst und sanktioniert werden kann. Die Daten der Plattformen lassen sich auch nutzen, um Menschen vorausschauend zu manipulieren und ihr Verhalten zu lenken, zum Beispiel indem jede:r weiß, welche Probleme bei unerwünschtem Verhalten drohen.

China entwickelt ein datenbasiertes System, um Bürger:innen umfassend zu dirigieren: Digital erfasstes Verhalten fließt in einen persönlichen Social Score. Punktabzug gibt es für negatives Verhalten, etwa Schwarzfahren oder Diebstahl. Es drohen Nachteile für das persönliche Leben, etwa weniger günstige Kredite oder schlechtere Krankenversicherung. Aktuell wird das System in einigen Städten getestet. Viele vor allem westliche Nachrichtenmedien sehen darin den Anfang eines dystopischen Kontroll-Staats, der den Alltag der Bevölkerung bis ins Detail beherrscht. Als Vergleich werden gerne der Roman 1984 und die Serie Black Mirror zitiert.

Einige Expertinnen relativieren. In der Bevölkerung komme das System bisher gut an, und auch in Deutschland kennen wir gnadenlose Punktesysteme, die das Leben negativ mitbestimmen können: etwa die Schufa, das Flensburger Punktesystem oder Schulzeugnisse. Je nach Einschätzung ist der Social Score also ein etwas aufdringliches Anreizsystem – oder der Beginn des Tech-Totalitarismus. Klar ist: Ein Sozialkreditsystem wie dieses wird erst durch den Datenschatz von Plattformen mächtig, und einmal installiert lässt es sich massiv missbrauchen.

Beispiele aus der Vergangenheit

- 11.03.2016 Apple weigert sich, dem FBI bei der Entschlüsselung eines iPhones zu helfen, das einem getöteten Terroristen gehört hat (Zeit Online)

- 12.10.2016 Facebook, Instagram und Twitter kappen den Zugang für die ortsbasierte Social-Media-Suchmaschine „Geofeedia“, weil Strafverfolger damit unter anderem Teilnehmer:innen von Demonstrationen verfolgten (Heise Online)

- 06.06.2019 Deutsche Politiker:innen diskutieren, ob Polizeibehörden die Aufzeichnungen von Assistenzwanzen, sogenannten Smartspeakern, auswerten dürfen (Spiegel)

- 16.12.2019 Ein technisch so nicht umsetzbarer Entwurf der Bundesregierung sieht vor, dass Plattformen auf Anfrage die Passwörter von Verdächtigen herausgeben müssen (Süddeutsche)

5. Das Teilhabe-Problem

Die wirtschaftliche Rolle: Eine Plattform darf Nutzungsbedingungen selbst definieren. Sie darf Nutzer:innen rauswerfen, wenn sie dagegen verstoßen, und sie kann die Hürden festlegen, die Nutzer:innen mindestens erfüllen müssen, um überhaupt dabei zu sein. Zum Beispiel darf Amazon einen Account sperren, wenn Nutzer:innen zu oft gekaufte Ware zurücksenden. Soziale Netzwerke wie YouTube, Facebook und Twitter können Nutzer:innen bannen, die politisch unerwünschte Standpunkte äußern. Die meisten großen Plattformen sperren Accounts, die sie für fake halten, um Betrug zu verhindern.

Die politische Rolle: Hat eine Plattform ein Monopol, bedeutet der Rausschmiss für Nutzer:innen den Ausschluss von gesellschaftlicher Teilhabe.

Wer heute bei Spotify rausfliegt, könnte seine Musik auch bei Deezer oder Apple Music hören. Für Nachwuchs-Musiker:innen wäre eine Karriere ohne Spotify dagegen schon heute ein Problem. Der Wendepunkt ist erreicht, sobald sich Plattformen mindestens ein Oligopol erarbeitet haben. In Zukunft könnten zum Beispiel Supermärkte von Amazon den Lebensmittelhandel in einigen Regionen beherrschen. Der Ausschluss von Amazon könnte dann bedeuten, dass Menschen ihre Grundversorgung mit Lebensmitteln verlieren.

Facebook zum Beispiel ist heute schon in einigen Regionen die einzige relevante Social-Media-Plattform. Ein Rausschmiss aus Facebook hätte dort drastische Folgen für das soziale Leben. Wenn die Möglichkeit der Teilhabe an einer Plattform von besonderem öffentlichen Interesse ist, braucht es andere Sanktionen als Rausschmeißen, Sperren und Blockieren.

Beispiele aus der Vergangenheit

- 15.12.2015 Das Klarnamen-Gebot von Facebook diskriminiert Transpersonen und Menschen, die sich durch andere Namen vor Verfolgung schützen (Guardian)

- 23.02.2016 PayPal sperrt Benutzerkonto wegen eines falschen Wortes in der Betreffzeile (FAZ)

- 30.01.2019 E-Mail-Anbieter machen es Menschen mit zweideutigen Nachnamen schwer, einen Account anzulegen (Vice)

- 05.05.2019 Twitter sperrt den Account der SPD-Politikerin Sawsan Chebli (Spiegel)

6. Das Infrastruktur-Problem

Die wirtschaftliche Rolle: Als Teil der freien Wirtschaft kann eine Plattform tun und lassen, was sie möchte. Sie kann ihre Angebote ändern, die Preise erhöhen, sich aus einem bestimmten Markt zurückziehen oder einfach komplett dichtmachen.

Die politische Rolle: Durch Disruption und Netzwerkeffekte können Plattformen alternativlos werden und müssen als Teil der öffentlichen Grundversorgung gelten.

Stellen wir uns eine Region ohne öffentlichen Nahverkehr vor, die sich komplett auf Carsharing-Dienste verlassen muss. Oder eine Zukunft, in der Amazon der einzige Lebensmittelhändler ist. Oder eine Zukunft, in der Google nicht nur die praktischste, sondern auch die einzige Suchmaschine ist. Die Plattformen könnten ihr Monopol ausnutzen, absurde Gebühren einführen, Preise erhöhen, den Datenschutz runterfahren oder sich mal eben aus finanziell weniger ertragreichen Regionen zurückziehen.

Noch gibt es für die Dienstleistungen der meisten großen Plattformen mehr oder weniger annehmbare Alternativen. Es kann aber zu einer Situation kommen, in der Plattformen plötzlich Grundversorgerinnen werden. Dann wären die Plattformen Teil der öffentlichen Infrastruktur und müssten stärker als sonst auch im Interesse des Allgemeinwohls handeln. Zugleich müssten Plattformen umso mehr vor politischer Instrumentalisierung wie Überwachung geschützt werden.

Im Jahr 2013 hat der Bundesgerichtshof die „zentrale Bedeutung“ des Internetzugangs hervorgehoben, Nachrichtenmedien machten daraus: Internet als Grundrecht. Und damit möglichst alle Menschen in Deutschland telefonieren können, gibt es das Telekommunikationsgesetz. Auf dessen Grundlage verpflichtet die Bundesnetzagentur Anbieter zum Ausbau der Netze, auch in Regionen, in denen sich der Ausbau finanziell nicht lohnt.

Stellt sich die Frage, ab wann auch andere Dienstleistungen der großen Plattformen so eng zum Leben gehören, dass neue „Grundrechte“ nötig werden, die der Staat durch verbindliche Regeln sichern muss: etwa ein Grundrecht auf Zugang zu einer unabhängigen Online-Suchmaschine, ein Grundrecht auf einen Online-Bezahldienst oder ein Grundrecht auf den Zugang zu einem Online-Shop.

Beispiele aus der Vergangenheit

- 26.11.2018 Die Bundesnetzagentur verpflichtet Netzbetreiber, bis Ende 2022 mindestens 98 Prozent der Haushalte mit mobilem Internet zu versorgen (Spiegel)

7. Das Freelancing-Problem

Die wirtschaftliche Rolle: Mit Hilfe von Plattformen können Nutzer:innen Geld verdienen, indem sie Produkte und Dienstleistungen verkaufen. Funktioniert die Vermittlung durch die Plattform besonders gut, kann sie für viele sogar zur einzigen Einnahmequelle werden: Es entstehen hauptberufliche Plattform-Freelancer:innen. Sie arbeiten zum Beispiel als YouTuber:innen, Uber-Fahrer:innen oder Online-Shop-Verkäufer:innen, die vorrangig über Amazon verkaufen. Trotzdem ist die Plattform nicht automatisch Arbeitgeberin, sondern nur Vermittlerin. Sie kann jederzeit ihre Regeln und Funktionsweise ändern und dadurch auch die Arbeitsbedingungen. Das Ergebnis: Eine Entscheidung der Plattform kann für Nutzer:innen den Geldhahn auf- oder zudrehen, über Wohlstand oder Geldnot entscheiden. Als selbstständige Arbeitnehmer:innen können sie in einem finanziellen Notfall keine Hilfe von der Plattform erwarten.

Die politische Rolle: Plattformen haben eine soziale Verantwortung gegenüber den Menschen, die sich finanziell von ihnen abhängig machen.

Der Reiz einer Plattform besteht darin, dass Nutzer:innen dort nur so viel Zeit reinstecken müssen, wie sie gerade möchten. Hier ein YouTube-Video über gesammelte Pokémon-Figuren, dort ein AirBnB-Inserat, damit die Wohnung im Sommerurlaub nicht leer steht. Auf den ersten Blick will eine Plattform gar nicht zur Arbeitgeberin werden. In vielen Fällen tut sie das aber. Vor allem wenn eine Plattform durch Disruption bestehende Arbeitsplätze verdrängt, zum Beispiel Uber in der Taxi-Branche einiger Länder. Hinzu kommen neue Berufsgruppen, etwa Influencer:innen oder Cam-Sexarbeiter:innen, die es ohne Plattformen nicht geben würde.

Während die Konzerne hinter erfolgreichen Plattformen Milliarden-Gewinne erzielen, entsteht in der Nutzer:innenschaft ein Plattform-Prekariat aus Freelancer:innen. Viele sind bereit, für Ihre Arbeit auf der Plattform jede Menge Pflichten einzugehen: Sie optimieren ihr Angebot entsprechend der Plattform-Regeln und Algorithmen, lassen die erbarmungslosen Bewertungsmechanismen über sich ergehen, pflegen die Community und investieren ihre gesamte Arbeitszeit, um im Wettbewerb mit den anderen Freelancer:innen zu bestehen. Im Gegenzug erhalten sie aber nur wenig Rechte.

Dahinter steht eine sozialpolitische Frage: Ab wann sollte eine Plattform für ihre Geld verdienenden Nutzer:innen mehr Verantwortung übernehmen? Ab wann verdienen Plattform-Freelancer:innen Mindestlohn, Sozialversicherung, Kündigungsschutz? Klar, viele genießen die Unabhängigkeit des Freelancer:innen-Lebens und wünschen es sich nicht anders. Das Problem ist aber, dass es dazu auch keine Alternative gibt. Es fehlen arbeitsrechtliche Lösungen für mehr soziale Sicherheit von Plattform-Freelancer:innen.

Beispiele aus der Vergangenheit

- seit 2016 YouTuber:innen fürchten um ihre finanzielle Existenz, seitdem YouTube an den Regeln für Werbe-Einnahmen schraubt (Polygon)

- 23.05.2018 Uber übernimmt einige Versicherungsfälle für besonders aktive Fahrer:innen, aber nur in Europa (Handelsblatt)

- 03.11.2019 Deutsche YouTuber:innen fordern zusammen mit der Gewerkschaft IG Metall bessere Arbeitsbedingungen (Tagesschau)

- 15.11.2019 Uber soll 642 Millionen Dollar Sozialabgaben in New Jersey nachzahlen (Heise Online)

Die Zukunft der Plattform-Probleme

In der Öffentlichkeit wurde in der zweiten Hälfte der Zehnerjahre vor allem das Meinungsmacht-Problem diskutiert. Im Fokus standen dabei Pegida und die neue Rechte, rechter und islamistischer Extremismus, Donald Trump und die AfD. Sie alle sind Bedrohungen der westlichen, freiheitlichen Demokratie, sie alle nutzen intensiv soziale Plattformen, rekrutieren und mobilisieren dort ihre Anhänger:innen.

Die Debatte um die Meinungsmacht der Plattformen ist also nur ein Schauplatz in einem viel größeren Konflikt: der Gefährdung der westlichen Demokratie, vor allem durch rechtsoffenen bis rechtsextremen Populismus. Dieser Konflikt zwingt Plattformen zunehmend dazu, Stellung zu beziehen. Neutral und unpolitisch zu bleiben erweist sich im Lauf des Zehnerjahre als zunehmend unmöglich. Im November 2019 sperrt Facebook nach langem Zaudern white nationalists, außerdem verschärft Facebook kontinuierlich die Regeln gegen sogenannte Hate Groups und Hate Speech. Gruppenbezogene Menschenfeindlichkeit wird auf vielen sozialen Plattformen immer weniger toleriert; in den Augen rechtsextremer Menschen rücken die Plattformen nach links.

Gleichzeitig entwickeln rechtsoffene bis rechtsextreme Communitys Strategien, um die Debatten in sozialen Medien gezielt zu stören und eskalieren zu lassen. Kleine Gruppen hyperaktiver Nutzer:innen hacken die sozialen Codes der Plattformen und missbrauchen die entdeckten Lücken. Sie plustern sich zu scheinbaren Mehrheiten auf, kapern Hashtags und Kommentarspalten, blenden Medien und Politik. Engagierten Nutzer:innen machen sie durch gezielte Hasskampagnen das Leben zur Hölle, vor allem wenn sie nicht rechts, weiß, cis, hetero und männlich sind.

Es wäre nur ein Teil der Wahrheit, wenn man sagt: Soziale Plattformen haben ein Rechtsextremismus-Problem, denn vor allem hat die Gesellschaft dieses Problem, und dagegen können Plattformen nur bedingt etwas ausrichten. Gesellschaftliche Probleme wie struktureller Rassismus lassen sich nicht durch technische Maßnahmen wie Plattform-Regulierung lösen. Je mehr sich künftig die Konflikte zwischen eher linken und eher rechten Gesellschaftsgruppen verschärfen, desto drängender wird das Meinungsmacht-Problem der Plattformen.

Viele Jahre lang war es zudem Alltag, dass alle wichtigsten Plattformen der westlichen Welt aus den USA stammen. Seit 2018 ist das anders. TikTok, die meist gehypte Plattform der späten Zehnerjahre, kommt aus China. In Deutschland hat sie bereits 5,5 Millionen Nutzer:innen. Der CEO von TikTok, Zhang Yiming, hat der chinesischen Regierung vorauseilenden Gehorsam gelobt. Er verschrieb sich 2018 in einem öffentlichen Brief der public opinion guidance, also der „Lenkung der öffentlichen Meinung“. Wie sich das auf das Zensur-Problem der Plattform auswirkt, haben jüngste Recherchen gezeigt.

Das Magazin netzpolitik.org deckte Ende 2019 durch interne Quellen auf: Bei TikTok herrscht ein Spaßdiktat. Hinter der Gute-Laune-Plattform stecken Zensur und restriktive Moderation. Riesige Teams aus TikTok-Moderator:innen haben unliebsame Inhalte gelöscht oder in der Reichweite begrenzt. Tanzende Teenager:innen und süße Tierbabys waren erwünscht, nicht aber Demonstrationen und Gewalt, die Darstellung von Politiker:innen und Menschen mit Behinderung.

Inzwischen hat die Plattform zwar Fehler eingestanden und Besserung gelobt; was genau sich ändern soll, steht aber noch nicht fest. Klar ist: Das autoritäre Regime in China versteht Meinungsfreiheit anders als die liberale USA. Und die politische Kultur im Herkunftsland einer Plattform hat weltweit Einfluss auf die Plattform-Probleme. Gut möglich, dass sich bald noch mehr chinesisch dominierte Plattformen weltweit verbreiten, zum Beispiel WeChat oder Alibaba. Den bekannten Plattform-Problemen würde das eine neue Form geben.

Vom Infrastruktur- und Teilhabe-Problem hatten wir in den Zehnerjahren nur eine Vorahnung. Das wird sich ändern, sobald neue Generationen wie selbstverständlich mit den Angeboten der Plattformen aufwachsen und Alternativen verschwinden. In Zukunft könnte zum Beispiel das Bargeld abgeschafft werden, und unsere Enkel:innen lachen sich schlapp, dass wir einst Münzen, unpraktische Scheiben aus Metall!, in unseren Taschen herumgeschleppt haben. Zugleich könnten sich die Enkel:innen wundern, dass es bestimmte Formen sozialer Ungerechtigkeit früher nicht gab: zum Beispiel Menschen, die plötzlich um Essen betteln müssen, weil irgendjemand ihren Account bei der vorherrschenden Online-Bezahlplattform gesperrt hat.

Für neue Generationen werden die Umwälzungen von heute bereits schnöder Alltag sein. Warum hinterfragen, was schon seit der eigenen Geburt so gewesen ist? Deshalb ist vor allem beim Überwachungs- und Polizei-Problem keine Zeit zu verlieren. Konservative Regierungen, nicht nur in Deutschland, beschneiden kontinuierlich die digitalen Rechte ihrer Bürger:innen, etwa durch Kamera-Überwachung, Gesichtserkennung, Vorratsdatenspeicherung, Staatstrojaner.

Für die breite Öffentlichkeit sind diese Einschnitte oft zu kleinteilig und zu technisch, die große Empörung bleibt aus. Aber diese Trägheit bewirkt, dass wir den kommenden Generationen eine weniger freie Welt hinterlassen. Bekämpft wird die Erosion unserer digitalen Freiheitsrechte derzeit vor allem durch Lobbyarbeit und Aktivismus, durch investigativen Journalismus und Klagen vorm Verfassungsgericht. Die deutsche Gesetzgebung der vergangenen Jahrzehnte weist deutlich in Richtung Überwachungsstaat – mit vor allem Plattformen als Datenquellen –, und es liegt allein am Engagement der Zivilgesellschaft, dass sich das ändert.